Koncepcje: inteligentny system (IntS), inteligentny system sterowania (IntSU). Podsumowanie: Inteligentne systemy sterowania Główne cele i zadania

UDC 004.896

I. A. Shcherbatov

INTELIGENTNE STEROWANIE SYSTEMAMI TECHNICZNYMI ROBOTA W NIEPEWNOŚCI

Wprowadzenie

Inteligentne sterowanie - zastosowanie metod sztucznej inteligencji do sterowania obiektami o różnym charakterze fizycznym. W dziedzinie sterowania systemami robotycznymi najpowszechniej stosowane są metody sztucznej inteligencji. Wynika to przede wszystkim z autonomii robotów i konieczności rozwiązywania przez nie niesformalizowanych zadań twórczych w warunkach niepełnej informacji i różnego rodzaju niepewności.

Określona klasa problemów do niedawna pozostawała prerogatywą inteligencji naturalnej: operator obiektu sterującego, inżynier, naukowiec, czyli osoba. Współczesne postępy w dziedzinie teorii automatyki, inteligentne metody formalizowania zadań półstrukturalnych i zarządzania złożonymi systemami technicznymi pozwalają na wdrażanie bardzo złożonych systemów robotycznych, do których należą mobilne platformy robotyczne, elastyczne linie automatyczne i roboty z systemem Android.

Systemy robotyczne działają w warunkach niepełnej informacji wejściowej, kiedy fundamentalna niemożność pomiaru wielu parametrów nakłada istotne ograniczenia na program sterujący. Prowadzi to do konieczności opracowania bazy algorytmów, które na podstawie znaków pośrednich i mierzonych wskaźników pozwolą wyliczyć parametry niezmierzone.

Niepewność otoczenia zewnętrznego, w którym funkcjonuje system robotyczny, powoduje konieczność uwzględnienia w systemie sterowania różnego rodzaju kompensatorów, modułów do adaptacji, gromadzenia i rankingu informacji.

Sformułowanie problemu

Celem badań było ukształtowanie podejść do budowy inteligentnych systemów sterowania systemami robotycznymi, które są niezmienne ze względu na specyfikę funkcjonowania, z uwzględnieniem niekompletności informacji wejściowych oraz różnego rodzaju niepewności.

Aby osiągnąć ten cel, konieczne jest rozwiązanie szeregu powiązanych ze sobą zadań: analiza architektur inteligentnych systemów sterowania systemami robotycznymi; opracować uogólniony algorytm do sytuacyjnej identyfikacji systemu robotycznego; opracowanie uogólnionego schematu systemu sterowania robotem; opracowanie inteligentnych systemów sterowania dla robota manipulacyjnego, mobilnej platformy robotycznej i elastycznej zautomatyzowanej linii.

Metody badawcze

W toku badań wykorzystano metody ogólnej teorii automatyki, teorii zbiorów rozmytych, sieci neuronowe, analizę systemową oraz teorię ocen eksperckich.

Lokalizacja systemu robotycznego w środowisku zewnętrznym

Dla realizacji inteligentnych algorytmów sterowania priorytetem jest zadanie bieżącej identyfikacji sytuacji, w której znajduje się system robotyczny. Aby rozwiązać ten problem, opracowano schemat strukturalny systemu identyfikacji sytuacyjnej (rys. 1).

Jednostka widzenia technicznego i percepcji sensorycznej służy do określania zmian stanu środowiska zewnętrznego i przedstawiania mapy sensorycznej środowiska do dalszej obróbki. Mapa sensoryczna otoczenia to obraz sytuacji, w której znajduje się robot. Przedział czasowy budowy mapy sensora dobierany jest na podstawie specyfiki obszaru tematycznego.

Baza wiedzy

Operator

Intelektualny

berło

Identyfikator

algorytmy

Narządy technicznego widzenia i percepcji zmysłowej

Otoczenie zewnętrzne

Wykonawczy

mechanizmy

Postać: 1. Schemat blokowy systemu identyfikacji sytuacyjnej

Pamięć robocza, analogicznie do systemów ekspertowych, jest przeznaczona do przetwarzania informacji pochodzących z czujników i przetwarzanych z wykorzystaniem istniejącej bazy algorytmów i bazy wiedzy (KB) systemu robotycznego.

Podstawą algorytmów są algorytmy do wstępnego przetwarzania mapy sensorów (cyfrowe przetwarzanie sygnałów, rozpoznawanie obrazów dźwiękowych i obrazów), obliczania niezmierzonych parametrów (zależności funkcjonalne od mierzonych parametrów), przywracania kompletności informacji (sprawdzanie wiedzy pod kątem kompletności i niespójności, dostosowywanie wiedzy z uwzględnieniem niestacjonarności i zmiennych warunków zewnętrznych), operacje matematyczne itp.

Baza wiedzy to złożona struktura hierarchiczna, zawierająca a priori informacje o środowisku zewnętrznym, ustalone na etapie szkolenia, kompletna i spójna wiedza, jaką robot nabywa w procesie funkcjonowania i percepcji otoczenia zewnętrznego. Wiedza w bazie wiedzy jest uszeregowana według kryteriów trafności i aktualizowana z uwzględnieniem zmian w specyfice działania robota w oparciu o algorytmy adaptacji wiedzy.

Najważniejszym blokiem jest identyfikator sytuacji. To właśnie ten blok odpowiada za prawidłowe rozpoznanie obrazu sytuacji na podstawie mapy sensora. Informacje o wynikach z tego bloku mają decydujące znaczenie dla wyboru programu sterującego systemem robotycznym.

I wreszcie inteligentny interfejs, który jest niezbędny do komunikacji z operatorem. Operator steruje działaniem systemu zrobotyzowanego, a także monitoruje proces osiągania wyznaczonych celów. Z reguły komunikacja między robotem a operatorem powinna odbywać się za pomocą interfejsu w języku naturalnym w ograniczonym podzbiorze języka naturalnego.

Struktura systemu sterowania robotem w warunkach niepewności

Wdrażanie algorytmów i programów do inteligentnego sterowania systemami robotycznymi w warunkach niepewności wiąże się z szeregiem istotnych trudności.

Złożoność algorytmów wstępnego przetwarzania informacji wejściowych i niepewność strukturalna modelu zachowania samego systemu robotycznego determinują redundancję struktury inteligentnego systemu sterowania.

Aby rozwiązać problem sterowania robotem w warunkach niepewności zaprojektowano następującą architekturę inteligentnego systemu sterowania (rys. 2).

System identyfikacji sytuacyjnej (SID) powinien być częścią każdego inteligentnego systemu sterowania systemem robotycznym. Inteligentne urządzenie sterujące (IUU) zawiera BZ i jednostkę wyboru programu sterującego (BVPU). Celem tego bloku jest opracowanie działania sterującego dla układu napędów elektrycznych (ED) działających na układ mechaniczny (MS) robota.

Postać: 2. Schemat blokowy inteligentnego systemu sterowania systemem robotycznym

Systemy sterowania manipulatorami przemysłowymi

Tradycyjne systemy sterowania manipulatorami przemysłowymi są podzielone na kilka klas. Pierwsza klasa systemów to systemy sterowania oprogramowaniem.

System ciągłej kontroli korpusu roboczego manipulatora zakłada dostosowanie manipulatora do modelu odniesienia. Ten algorytm sterowania nie uwzględnia strat w manipulatorze MS i zakłada się, że cały wysiłek wywołany przez napędy jest przenoszony na korpus roboczy.

Zaprogramowany układ sterowania siłą w korpusie roboczym służy do sterowania nie tylko wektorem siły, ale także wektorem położenia ciała roboczego. System niezależnej kontroli ruchu i siły w korpusie roboczym manipulatora dla różnych stopni ruchliwości posiada dwie pętle sterowania ze sprzężeniem zwrotnym: położeniem i siłą.

W układzie sprzężonej kontroli ruchu i siły w korpusie roboczym manipulatora zadanie wektorem położenia korpusu roboczego jest korygowane o aktualną wartość wektora siły. Oznacza to, że gdy korpus pracujący się porusza, wielkość jego skoku jest korygowana siłą oddziaływania na środowisko zewnętrzne.

Adaptacyjne systemy sterowania wykorzystywane są przy wykonywaniu: operacji zabierania losowo położonego lub poruszającego się przedmiotu, spawania łukowego szwów o zmiennym położeniu, omijania ruchomych i nieprzewidzianych przeszkód. W tym celu stosuje się systemy adaptacyjne z pamięcią asocjacyjną.

Do sterowania manipulatorami przemysłowymi stosuje się również solidne systemy sterowania, które są obecnie szeroko stosowane w praktyce.

Wdrażanie inteligentnej kontroli

Problem funkcjonowania systemu robotycznego w warunkach niepewności jest wieloaspektowy.

Rozważ problem planowania zachowania systemu robotycznego w warunkach niepewności. Aby go rozwiązać, najbardziej celowe jest wykorzystanie technologii dynamicznych systemów ekspertowych. Baza wiedzy takiego systemu ekspertowego jest z czasem dostosowywana. Jeśli stosowana jest podstawa reguł produkcji, skład reguły produkcyjnej jest stale badany pod kątem kompletności i spójności. Ponadto, ze względu na algorytmy adaptacyjne, przestarzałe i nieaktualne reguły są aktualizowane i zastępowane. Jednocześnie szczególną uwagę zwraca się na kwestie nauczania systemu ekspertowego bez nauczyciela (samokształcenie), gdyż monitorowanie systemu wysoko wykwalifikowanego specjalisty jest ekonomicznie niecelowe.

Samouczący się lub samodostrajający się blok bazy wiedzy systemu ekspertowego wymaga dokładnych badań na etapie projektowania inteligentnego systemu sterowania systemem robotycznym.

mój. Od jakości tego etapu prac projektowych często decyduje skuteczność rozwiązania zadania. Powinien obejmować podsystemy do oceny kompletności i niespójności wiedzy, oceny jakości zarządzania i korygowania wiedzy.

Chronologicznie kolejnym etapem po zaplanowaniu zachowania może być problem wydawania poleceń sterujących do systemu robotycznego w języku naturalnym. Naszym zdaniem do stworzenia interfejsu w języku naturalnym najbardziej odpowiednim narzędziem implementacyjnym jest teoria zbiorów rozmytych.

Za pomocą zmiennych lingwistycznych zawierających określony, opisany wcześniej zbiór terminów, dokonuje się opisu obszaru tematycznego, ograniczonego systemu poleceń i obiektów, które wpływają na system robotyczny i zmieniają się pod jego działaniem. Zastosowane w tym przypadku metody fuzzyfikacji i defuzyfikacji oraz algorytmy wnioskowania rozmytego mają istotny wpływ na dokładność wypracowania działań sterujących i szybkość działania systemu robotycznego.

I wreszcie zastosowanie systemów sterowania siecią neuronową w systemach robotycznych. Główną zaletą sieci neuronowej jest to, że nie ma potrzeby znajomości ani tworzenia matematycznego modelu obiektu, ponieważ sieć neuronowa jest uniwersalnym przybliżeniem rozmytym.

Obiekt (system robotyczny) działa jak „czarna skrzynka”. Sieć neuronowa może pełnić rolę modelu odniesienia dla sterowanego systemu robotycznego. Należy zauważyć, że powinna to być ucząca się wielowarstwowa sieć neuronowa (identyfikator obiektu). Model sieci neuronowej jest dostrajany do obiektu sterującego przez niedopasowanie sygnałów wyjściowych obiektu i modelu. Stanowi również próbkę szkoleniową do regulacji i regulacji urządzenia sterującego zgodnie z wybranym kryterium jakości.

Wniosek

Analiza pozwoliła zsyntetyzować niezmienną ze względu na specyfikę funkcjonowania architekturę inteligentnego systemu sterowania systemami robotycznymi. Opracowany algorytm identyfikacji sytuacyjnej pozwala na budowanie wysoce informacyjnych map sensorowych środowiska zewnętrznego. Opisano główne podejścia do tworzenia inteligentnych systemów sterowania dla systemów zrobotyzowanych. Wskazano kierunki perspektywicznego rozwoju najbardziej efektywnych metod sztucznej inteligencji wykorzystywanych do realizacji urządzeń sterujących.

LISTA ODNIESIEŃ

1. Yurevich EI Podstawy robotyki. - SPb .: BHV-Petersburg, 2007. - 416 str.

2. Systemy manipulacji robotami / wyd. A.I. Korendyaseva. - M .: Mashinostroenie, 1989. - 472 str.

3. Burdakov SF Synteza wytrzymałych regulatorów z elementami elastycznymi: zbiór artykułów. naukowy. tr. - nr 443. Mechanika i procesy zarządzania. - SPb .: SPbSTU, 1992.

4. Protalinsky OM Zastosowanie metod sztucznej inteligencji w automatyzacji procesów technologicznych: monografia. - Astrachań: Wydawnictwo ASTU, 2004. - 184 str.

Artykuł wpłynął 13.01.2010

INTELEKTUALNE ZARZĄDZANIE SYSTEMAMI ROBOTYCZNYMI W WARUNKACH NIEPEWNOŚCI

I. A. Shcherbatov

Celem podanej pracy jest ukształtowanie podejść do budowy układów intelektualnego sterowania systemami robotyki, niezmiennych w stosunku do specyfiki funkcjonowania, z uwzględnieniem niekompletności informacji wejściowej i różnego rodzaju niepewności. Przeprowadzono analizę, która pozwoliła na syntezę architektury intelektualnego systemu sterowania systemami robotyki niezmiennymi w stosunku do specyfiki funkcjonowania. Opracowany algorytm identyfikacji sytuacyjnej pozwala budować dobre karty dotykowe otoczenia. Omówiono podstawowe podejścia do tworzenia intelektualnych systemów sterowania systemami robotyki. Przedstawiono kierunki perspektywicznego rozwoju najskuteczniejszych metod sztucznej inteligencji stosowanych do realizacji urządzeń uruchamiających.

Słowa kluczowe: system robotyki, robot, zarządzanie intelektualne, niepewność strukturalna, niekompletność informacji, karta dotykowa, sieć neuronowa, teoria zbiorów niewyraźnych, samoukający się system ekspertowy.

Jednym ze sposobów wyjścia z tej sytuacji jest zastosowanie inteligentnych metod sterowania, które implikują odrzucenie:

- - potrzeba uzyskania dokładnego modelu matematycznego obiektu;

- - orientacja na stosowanie „twardych” (zwykle liniowych) algorytmów tworzenia działań kontrolnych;

- - dążenie za wszelką cenę do wykorzystania technik syntezy znanych deweloperowi, które wcześniej pozytywnie sprawdziły się dla innych, prostszych klas obiektów.

Zanim przejdziemy do inteligentnego sterowania, nie sposób nie zauważyć uznanych na świecie i klasycznych trendów w sterowaniu obrabiarkami, wypracowanych przez krajowe szkoły naukowe. Są to prace Balakshin B.S., Bazrov B.M., Bzhozovsky B.M., Gornev V.F., Morozov V.P., Kolosov V.G., Ratmirov V.A., Solomentsev Yu.M., Pushha V.E., Sosonkina V.L., Timiryazeva V.A., Zakovorotny V.L. itd. . W szczególności prace poświęcone są stworzeniu systemów adaptacyjnej kontroli obrabiarek pod kątem jakości wytwarzania wyrobów. W pracach szczegółowo opisano elastyczną zautomatyzowaną produkcję (HAP), pozwalającą na obniżenie kosztów, zwiększenie niezawodności i elastyczności (dostosowanie) działania przy częstej zmianie programów sterujących. Tworzenie programów CNC i cechy ich realizacji w ramach zintegrowanej zautomatyzowanej produkcji są omówione w.

W pracy przedstawiono szczegółową analizę współczesnych metod sterowania procesami technologicznymi i urządzeniami, w której przedstawiono osiągnięcia współczesnej teorii sterowania, w szczególności zastosowania metod analitycznego projektowania regulatorów (AM Letov itp.), Sterowania modalnego ( GS Pospelov itp.), Odwrotne problemy dynamiki (Krut'ko P.D. i inne), niezmienna kontrola (Shchipanov G.V., Kulebakin V.S., Petrov B.N. itp.), Adaptacyjna kontrola (Tsipkin Ya.D. itp.) Itp. Należy zauważyć, że szczytem idei w syntezie systemów sterowania jest analityczny projekt sterowników. Zasadniczo inny sposób budowania systemów sterowania, oparty na synergetycznej teorii sterowania, opisano w. W pracach opisano zasady przemian ewolucyjnych i samoorganizacji, oparte na podejściu synergicznym, w systemie kontroli, którego współrzędne stanu oddziałują ze środowiskiem. Wszystkie te podejścia i zasady syntezy układów sterowania mają swoje zalety i wady, ale wszystkie łączy je to, że opierają się na matematycznym modelu obiektu sterowania uzyskanego w taki czy inny sposób, a model matematyczny jest układem różniczkowym. lub równania różnicowe opisujące fizyczną istotę procesów lub obiektów. Zasadniczo odmienne podejście do sterowania polega na zastosowaniu matematycznych modeli wiedzy o kontrolowanym obiekcie, tj. stosowanie inteligentnych metod sterowania. W odniesieniu do TO ten kierunek badań przedstawiono w pracach.

Kontrola intelektualna opiera się na idei budowania wysoce zorganizowanego ACS, opartego na wykorzystaniu modeli o zmiennej złożoności i niepewności, z realizacją takich nieodłącznych ludzkich funkcji intelektualnych, jak podejmowanie decyzji, planowanie zachowań, uczenie się i samokształcenie w zmieniające się środowisko. Uczenie się oznacza zdolność systemu do poprawy swojego zachowania w przyszłości (w odniesieniu do TO, do poprawy jakości przetwarzania), w oparciu o otrzymane w przeszłości eksperymentalne informacje o wynikach interakcji z czynnikami wpływającymi. Samokształcenie to szkolenie bez zewnętrznej regulacji, czyli bez instrukcji „nauczyciela” - operatora.

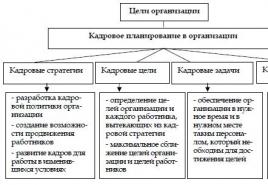

Inteligentny system sterowania (IMS) to taki, w którym wiedza o nieznanych cechach obiektu sterowania i otoczenia kształtuje się w procesie uczenia się i adaptacji, a uzyskane informacje są wykorzystywane w procesie automatycznego podejmowania decyzji, poprawia się jakość kontroli.

Niezbędną cechą IMS jest obecność bazy wiedzy zawierającej informacje (fakty), modele i reguły, które pozwalają wyjaśnić zadany problem sterowania i wybrać racjonalny sposób jego rozwiązania. O inteligentnych systemach mówi się często jako o systemach opartych na wiedzy. W zależności od charakteru realizowanych funkcji intelektualnych, czyli na poziomie intelektualnym, wyróżnia się ISU, intelektualne „w dużych” i „w małych”.

Według systemów sterowania inteligentne „w dużym” - to układy zorganizowane i funkcjonujące zgodnie z następującymi pięcioma zasadami (w całości).

- 1. Interakcja z rzeczywistym światem zewnętrznym za pomocą kanałów komunikacji informacyjnej.

- 2. Podstawowa otwartość systemu na wzrost inteligencji i poprawę własnego zachowania.

- 3. Dostępność mechanizmów prognozowania zmian w świecie zewnętrznym i zachowania własnego systemu w dynamicznie zmieniającym się świecie zewnętrznym.

- 4. Obecność wielopoziomowej struktury hierarchicznej, zbudowanej zgodnie z zasadą: zwiększona inteligencja i zmniejszone wymagania co do dokładności modeli wraz ze wzrostem poziomu hierarchii w systemie (i odwrotnie).

- 5. Trwałość funkcjonowania (prawdopodobnie z pewną utratą jakości lub wydajności, to znaczy z pewną akceptowalną degradacją) w przypadku zerwania połączeń lub utraty działań kontrolnych z najwyższych poziomów hierarchii struktury sterowania.

Inteligentne systemy sterowania „w drobiazgach” nie spełniają wyżej wymienionych zasad, ale są wykorzystywane w funkcjonowaniu wiedzy (np. W postaci reguł) jako sposób przezwyciężenia niepewności informacji wejściowych, niedokładności w opis kontrolowanego obiektu lub jego zachowania.

Na podstawie powyższego można wyciągnąć następujący wniosek. Z wieloma czynnikami wpływającymi na osiąganie jakości obróbki na maszynach do cięcia metali, „nieostrością” informacji o tych czynnikach, stochastycznością samego procesu skrawania, a także z różnorodnością metod zapewnienia danej obróbki dokładność, inteligentne systemy sterowania to obiecujący kierunek badań i rozwoju wyposażenia obrabiarek.

Obecnie najbardziej rozpowszechnione metody inteligentnego sterowania są związane z następującymi czterema klasami:

- - systemy ekspertowe (ES);

- - regulatory rozmyte (NR);

- - sieci neuronowe (NN);

- - algorytmy genetyczne (GA).

Systemy ekspertowe (expertystems) zajmują się zadaniami sztucznej inteligencji na najwyższym poziomie, pracując na informacjach symbolicznych w celu wyciągania wniosków o środowisku i formułowania decyzji zarządczych, biorąc pod uwagę charakter bieżącej (lub przewidywanej) sytuacji. Systemy eksperckie gromadzą i manipulują wiedzą heurystyczną, próbując naśladować zachowanie eksperta.

Rysunek 1.2 przedstawia przykład konstrukcji eksperckiego regulatora, który jest połączeniem ES i tradycyjnego regulatora (lub systemu regulatorów) stosowanego do zarządzania konserwacją. Bardziej złożoną strukturę (ze szczegółowym uszczegółowieniem poszczególnych bloków ES) zaproponowano w modelu działania układu technologicznego, które opierają się na zasadzie podejmowania decyzji o dokonywaniu korekcji predykcyjnej w procesie wytwarzania części z uwzględnieniem specyficzna sytuacja. System ekspertowy, zarówno na rysunku 1.2, jak i na rysunku 1.2, tworzy wyższy, nadzorczy poziom zarządzania i obejmuje szereg podsystemów.

Podsystem identyfikacji i prognozowania - zapewnia znalezienie modelu matematycznego obiektu sterowania bezpośrednio w procesie funkcjonowania, na podstawie wyników obserwacji jego zmiennych wejściowych / wyjściowych. Oznacza to, że do zadań bloku należy pozyskiwanie informacji niezbędnych do podejmowania decyzji. Blok ten realizuje programową regulację ruchów ciał roboczych, mierzy i identyfikuje parametry stanu środowiska zewnętrznego - F, działania kontrolne - U, wyniki systemu AIDS - Y.

Baza danych zawiera stale aktualizowane dane (poprzednie, aktualne, prognozy) dotyczące charakterystyki systemu AIDS i środowiska zewnętrznego, a także informacje o wartościach granicznych (krytycznych, maksymalnych dopuszczalnych) odpowiednich parametrów. Baza wiedzy zawiera wiedzę o specyfice danego celu, celach, strategiach i algorytmach sterowania, o wynikach identyfikacji i prognozowania cech systemu AIDS.

Podsystem wnioskowania dobiera racjonalną (najbardziej odpowiednią w momencie przetwarzania określonej części do konserwacji) strukturę i parametry sterownika, ewentualnie algorytmy identyfikacji i prognozowania.

Podsystem interfejsów ma za zadanie zorganizować interaktywny tryb wypełniania bazy wiedzy z udziałem eksperta (tryb szkoleniowy) oraz zapewniający komunikację z użytkownikiem-operatorem (pracownik-profesjonalista), w tym wyjaśnienie mechanizmu podejmowania określonych decyzji zarządczych (Tryb pracy).

Różnica między architekturą systemu ekspertowego pokazaną na rysunku 1.2 a architekturą konwencjonalnych (statycznych) systemów ekspertowych polega na tym, że zapewnia on następujące ważne funkcje:

- * budowanie dynamicznego modelu obiektu i jego otoczenia;

- * utrzymywanie kontaktu ze światem zewnętrznym (czujniki, DBMS, regulatory, inne ES).

Ta okoliczność pozwala nam zaklasyfikować rozważany system ekspercki jako dynamiczny („aktywny”) system ekspercki lub systemy eksperckie czasu rzeczywistego, zdolne do uzupełnienia utraconego wkładu profesjonalnego pracownika swoim doświadczeniem, wiedzą i umiejętnościami w osiąganiu jakości przetwarzania .

Fuzzycontrollers. Idee logiki rozmytej, po raz pierwszy wyrażone w 1964 roku przez znanego specjalistę w dziedzinie teorii systemów, Amerykanina L. Zadeha, znalazły swoje pierwsze zastosowanie w problemach sterowania rzeczywistymi obiektami technicznymi w Europie. W 1974 roku prace angielskich naukowców E.H. Mamdani i S. Assilian, poświęconych problematyce regulacji instalacji wytwornicy pary za pomocą specjalnie zaprojektowanych reguł rozmytych (produktów).

Typową strukturę IMS z NR przedstawiono na rysunku 1.3. Dla uproszczenia przyjmiemy, że obiekt sterujący (na przykład napęd posuwu oparty na silniku prądu stałego (DCM)) jest jednowymiarowy, to znaczy ma jedno wejście (sygnał sterujący - u) i jedno wyjście (wał silnika prędkość obrotowa - y). Błąd sterowania e, który jest różnicą między działaniem nastawczym a wyjściem obiektu (zmienna kontrolowana) y, jest podawany na jedno z wejść modułu fuzzification. Sygnał różniczkujący obliczony za pomocą urządzenia różnicującego (DU) jest odbierany na drugim wejściu tego bloku.

Celem bloku fuzzification jest zamiana wartości sygnałów błędu e i ich pochodnych na zmienne językowe określone przez funkcje przynależności. Tutaj odpowiednio А i i В j są wartościami (wyrażeniami) przyjmowanymi przez zmienne językowe „Błąd kontroli” i „Pochodna błędu”. Przykład konstrukcji funkcji członkostwa i jest pokazany na rysunku 1.3, gdzie zastosowano następujące oznaczenia:

Z - „blisko zera” (zego);

МР - „średnio pozytywny” (średnio pozytywny);

LP - „Duży pozytyw” (duży pozytywny);

MN - „średni ujemny”;

LN - „Duży negatyw” (duży ujemny).

Wiedza przechowywana jest w bazie wiedzy w postaci reguł, których lewa część zawiera warunki dotyczące powyższych wartości zmiennych językowych „Błąd kontroli” i „Pochodna błędu”, a prawa część zawiera stwierdzenia dotyczące wartości zmiennej językowej „Przyrost działania sterującego” (indeks k oznacza tutaj k-ty moment tk). Zasady te mogą przybrać następującą formę:

- 1) JEŻELI (błąd sterowania \u003d bliski zeru) AND (pochodna błędu \u003d bliski zera), TO (przyrost regulacji \u003d bliski zeru);

- 2) JEŻELI (błąd kontrolny \u003d średnia dodatnia) ORAZ (pochodna błędu \u003d duży ujemny), TO (przyrost kontroli \u003d średnia dodatnia) itd.

Zakłada się, że realizacja tych zasad gwarantuje spełnienie określonych wymagań stawianych układowi, związanych z zapewnieniem pożądanego rodzaju jego funkcji przejściowej (zadana prędkość, monotonia, słabe oscylacje procesu przejściowego, np. W zakresie sterowania i zakłócenia). do serwonapędu maszyny do cięcia metalu). Możliwy wariant przypisania funkcji przynależności określających podstawowe wartości zmiennej językowej „Przyrost akcji sterującej” w postaci jednopunktowych zbiorów rozmytych (singletonów) pokazano na rysunku 1.4.

Mechanizm wnioskowania oparty jest na metodzie „maksimum-minimum” lub „maksimum-iloczynu”. Zastosowanie tych metod pozwala na otrzymanie wynikowej funkcji przynależności zmiennej językowej „Przyrost akcji sterującej” (rysunek 1.4) z uwzględnieniem określonych (tj. Mierzonych w czasie tk) wartości sygnałów ek oraz - wejścia kontrolera rozmytego.

I wreszcie przejście od uzyskanego zbioru rozmytego, opisanego funkcją przynależności, do jedynej (wyraźnej) wartości zmiennej wyjściowej, odbywa się w bloku defuzyfikacyjnym metodą środka ciężkości.

W przypadku rozpatrywanym na rysunku 1.4 wartość tę oblicza się jako

gdzie są wartościami funkcji przynależności w punktach -c 1, -c 2, 0, -c 1, -c 2, nazywane poziomami aktywności odpowiednich reguł i obliczane przy użyciu mechanizmu wnioskowania.

Wynik kontrolera rozmytego u k znajduje się według wzoru

gdzie u k-1 jest poprzednią wartością działania kontrolnego u; jest przyrostem obliczonym w k-tym cyklu pracy regulatora.

Innym rodzajem regulatora rozmytego jest regulator typu Sugeno. W tym przypadku tylko lewa część reguł (warunków) zawiera zmienne językowe; Po prawej stronie tych reguł (wyjść) są liniowe kombinacje zmiennych wejściowych regulatora plus składowa DC (przesunięcie). Na przykład rozmyte reguły mogą wyglądać tak:

1) JEŻELI (błąd sterowania \u003d bliski zeru) AND (pochodna błędu \u003d bliski zera) WTEDY

2) JEŻELI (błąd kontrolny \u003d średnia dodatnia) ORAZ (pochodna błędu \u003d duży ujemny) TO

Tutaj - określone (wybrane przez eksperta) współczynniki liczbowe; - wartości sygnału błędu i jego pochodnej zmierzone w k-tym cyklu. Wynikowy wynik jest średnią ważoną wyników każdej reguły (1.3)

gdzie jest poziom aktywności i-tej reguły; N to liczba takich reguł; jest przyrostem obliczonym przy użyciu i-tej reguły dla określonych wartości.

Główną zaletą stosowania rozmytych sterowników w sterowaniu TO jest możliwość efektywnego sterowania złożonymi obiektami dynamicznymi wchodzącymi w skład systemu AIDS, w warunkach niepewności ich charakterystyki poprzez modelowanie mechanizmu przetwarzania wiedzy przez analogię z zachowaniem wysoko wykwalifikowanego pracownika (operator).

Sieci neuronowe. Historia sztucznych sieci neuronowych zaczyna się od prac amerykańskich naukowców W.Mccullocha, W.Pittsa (1943 - model formalnego neuronu) i F. Rosenblatta (1958 - jednowarstwowa sieć neuronowa, którą nazwał perceptronem) . Obecnie sieci neuronowe (NN) to równoległe struktury obliczeniowe modelujące procesy biologiczne powszechnie kojarzone z procesami zachodzącymi w ludzkim mózgu. NN mają umiejętność zdobywania wiedzy na dany temat, uczenia się na przykładach i dostosowywania swoich wag w celu interpretacji prezentowanych im wielowymiarowych danych.

Rysunek 1.5 przedstawia schemat blokowy sieci neuronowej o bezpośredniej propagacji - perceptron wielowarstwowy. Okręgi (wierzchołki) oznaczają elementarne przetworniki informacji - neurony, a strzałki (łuki) - połączenia między nimi, które mają różną „siłę” (wagi połączeń synaptycznych). Jak widać na rysunku 1.5, rozważany perceptron składa się z kilku warstw neuronów:

- * warstwa wejściowa, do której dostarczany jest zestaw sygnałów wejściowych;

- * jedna lub więcej „ukrytych” (pośrednich) warstw;

- * warstwa wyjściowa neuronów.

Istotą procesu uczenia się NN jest wykonanie następującej wieloetapowej procedury.

Krok 1. Zestaw treningowy jest ustawiony („książka problemów”)

których elementami są pary treningowe. W tym przypadku - pierwszy wektor wejściowy (lub pierwszy obraz wejściowy) prezentowany sieci neuronowej; - wektor reakcji odniesienia (wymagany) NS w odpowiedzi na 1 wektor wejściowy; L to liczba różnych par treningowych.

Krok 2. Stan początkowy sieci NN jest ustalany przez przypisanie kilku przypadkowych (małych) wartości wszystkim jej wagom. jest wagą połączenia łączącego wyjście i-tego neuronu k-tej warstwy z wejściem j-tego neuronu (k + 1) -tej warstwy.

Krok 3. Wektor wejściowy jest podawany na wejście sieciowe; określa się reakcje neuronów warstwy wyjściowej.

Krok 4. Oblicz różnicę między żądaną odpowiedzią sieci a jej rzeczywistą wydajnością, to znaczy, jak również całkowity kwadrat błędu

Krok 5. Wagi sieci neuronowej są korygowane w taki sposób, aby zmniejszyć błąd.

Krok 6. Kroki 3-5 są powtarzane dla każdej pary zbioru uczącego, aż błąd całego zestawu osiągnie małą, z góry określoną wartość E *.

Wynikiem uczenia jest takie ustawienie wag połączeń synaptycznych, w którym każdy wektor wejściowy jest dopasowywany przez sieć do wymaganego (lub zbliżonego do niego) wyjścia.

Jednym z pierwszych algorytmów, które okazały się skuteczne w nauczaniu wielowarstwowej sieci neuronowej, był algorytm wstecznej propagacji (Bask-ProgationAlgorithm) zaproponowany w 1986 roku przez Rummelharta (USA) i jego współpracowników, który następnie przeszedł liczne zmiany i ulepszenia.

Obecnie znanych jest ponad 200 odmian NS. Oprócz wspomnianych powyżej perceptronów wielowarstwowych są to:

- * dynamiczne (rekurencyjne) sieci neuronowe;

- * sieci oparte na radialnych funkcjach bazowych;

- * Sieci Hopfield;

- * Sieci Kohonena;

- * neokognitrony itp.

Rysunek 1.6 przedstawia przykład wykorzystania NN do rozwiązania problemu sterowania złożonym obiektem dynamicznym (jak w przykładzie ze sterownikiem rozmytym, rozważane jest utrzymanie zadanej prędkości dla napędu z silnikiem prądu stałego). W tym przypadku NN działa jako nieliniowy regulator, który po zakończeniu procesu uczenia zapewnia minimalne niedopasowanie między wyjściami modelu odniesienia (EM) i ACS TO jako całości.

Zalety stosowania wielowarstwowych NS jako regulatorów TO wyjaśnia ich zespół właściwości: 1) sygnały w takich NS, podobnie jak w automatycznych układach sterowania, propagują się w jednym kierunku do przodu; 2) kluczową rolę w tworzeniu niezbędnych nieliniowych algorytmów sterowania odgrywają uniwersalne właściwości aproksymacyjne tych sieci; 3) zdolność wielowarstwowej sieci neuronowej do uczenia się daje właściwości adaptacyjne; 4) zdolność sieci neuronowych do równoległego przetwarzania zarówno sygnałów analogowych, jak i dyskretnych sprawia, że \u200b\u200bnaturalne jest ich wykorzystanie do sterowania obiektami wielowymiarowymi. Wdrażanie neurokontrolerów opartych na wyszkolonych sieciach neuronowych nie powoduje fundamentalnych trudności: istniejące narzędzia mikroprocesorowe mogą w pełni realizować funkcje sieci neuronowych. Włączenie wielowarstwowego NN do pętli sterowania rozszerza przestrzeń fazową obiektu i zwiększa liczbę jego stopni swobody, umożliwiając w ten sposób syntezę optymalnych praw sterowania.

Algorytmy genetyczne (algorytmy genetyczne). To duża grupa metod wyszukiwania adaptacyjnego i optymalizacji wieloparametrowej, które w ostatnich latach intensywnie rozwijają się zarówno pod kątem ich samodzielnego zastosowania, jak i w połączeniu z innymi metodami inteligentnego sterowania.

Już sama nazwa tych algorytmów wskazuje, że ich pochodzenie wiąże się z wykorzystaniem zasad doboru naturalnego i genetyki. Tradycyjne metody przeszukiwania zwykle zakładają różniczkowalność badanej funkcji celu ze względu na parametry iz reguły stosują procedury gradientowe. Algorytmy genetyczne (GA) różnią się od konwencjonalnych metod optymalizacji w wielu okolicznościach. W istocie GA są metodą równoległego poszukiwania globalnego ekstremum, polegającą na wykorzystaniu w procesie poszukiwań kilku odpowiednio zakodowanych punktów (kandydatów na rozwiązania) jednocześnie, które tworzą populację rozwijającą się według pewnych losowych praw. Zastosowane w tym przypadku mechanizmy selekcji, najpierw jasno sformułowane przez Karola Darwina („Najlepiej przystosowany przeżyje!”), Pozwalają nam wyeliminować najmniej odpowiednie opcje i odwrotnie, podkreślić, a następnie wzmocnić pozytywne cechy tych opcji, które najpełniej osiągnąć cel.

Przedstawmy zakres zadań, które można rozwiązać za pomocą AH w odniesieniu do TO.

Zadania optymalizacyjne zajmują jedno z centralnych miejsc w projektowaniu różnych klas ACS TO. Przyczyną tego jest naturalna tendencja do wybierania najprostszej opcji budowy systemu lub modelu przy jednoczesnym spełnieniu określonych wymagań co do jakości jego funkcjonowania (problem syntezy strukturalnej) lub poszukiwania optymalnych ustawień parametrów systemu wieloskładnikowego dla danej konstrukcji (problem syntezy parametrycznej). Podano kilka przykładów formułowania odpowiednich problemów.

Problem 1. Konieczne jest znalezienie optymalnego algorytmu do identyfikacji i przewidywania charakterystyk obiektu, używanego jako część IMS TO ze sterownikiem eksperckim (patrz Rysunek 1.2). Parametry, które należy zmieniać, to współczynniki numeryczne modelu regresji, liczba funkcji bazowych lub kolejność równań regresji. Funkcja celu jest błędem identyfikacji i prognozy, oszacowanym jako różnica między wyjściami obiektu sterowania i jego modelu w bieżącym (lub przyszłym) momencie.

Zadanie 2. Wymagane jest wybranie formy i względnego położenia funkcji członkostwa regulatora rozmytego zapewniającego daną jakość procesów sterowania w ACS TO. Parametry zmienne - współczynniki liczbowe a i, b j, c s funkcji przynależności (patrz rysunek 1.5); liczba funkcji członkostwa. Funkcja celu jest wskaźnikiem jakości (funkcjonalnym), którego minimum odpowiada referencyjnym procesom przejściowym.

Zadanie 3. Wymagane jest wybranie struktury (topologii, architektury) wielowarstwowego perceptronu używanego jako kontroler nieliniowy w ISU TO, pokazanego na rysunku 1.6. Zmienne parametry to liczba warstw i liczba neuronów w każdej warstwie sieci neuronowej. Funkcja celu to błąd uczenia się sieci, który jest niedopasowaniem między wyjściami obiektu a modelem odniesienia systemu.

We wszystkich powyższych przykładach problem optymalizacji przyjmuje następujące sformułowanie matematyczne: znajdź takie wartości parametrów zmiennych V 1, V 2, ..., V n, które zapewniają minimum funkcji celu f (V 1, V 2, ..., V n), pod warunkiem, że wskazane parametry V 1, V 2, ..., V n spełniają pewien zakres dopuszczalny. Określenie obszaru ograniczeń w każdym konkretnym przypadku jest podyktowane specyfiką rozwiązywanego problemu. Na przykład w Problemie 2 o typie regionu decyduje wybór granic przedziałów, w których poszukuje się poszukiwanych optymalnych parametrów funkcji przynależności. W Problemie 3 odpowiednie ograniczenia są związane z ograniczeniem maksymalnej dopuszczalnej złożoności badanej klasy NS itp.

Podczas korzystania z tradycyjnych algorytmów wyszukiwania wieloparametrowego do rozwiązania powyższych problemów pojawia się szereg trudności, do których należą:

- * gwałtowny wzrost kosztów obliczeniowych i czasu poszukiwań wraz ze wzrostem liczby zmiennych parametrów („przekleństwo wymiaru”);

- * lokalny charakter algorytmów wyszukiwania, związany z koniecznością obliczenia pochodnych (gradientu) funkcji celu na każdym etapie poszukiwań;

- * możliwość „zawieszenia” algorytmu wyszukiwania w sąsiedztwie jednego z lokalnych ekstremów;

- * niska odporność algorytmu na zakłócenia;

- * niska efektywność wyszukiwania w sytuacjach „wąwozu”.

Atrakcyjność GA polega właśnie na tym, że są one w dużej mierze pozbawione tych wad.

Zgodnie z terminologią AH, zapożyczoną z genetyki i teorii ewolucji przyrody żywej, zajmują się one populacją „osobników”, z których każda jest kandydatem do rozwiązania rozważanego problemu. Każdej osobie przypisywany jest określony „wskaźnik sprawności (sprawności)” w zależności od tego, jak skuteczny jest ten konkretny wariant rozwiązania problemu. Na przykład jedna z wyżej wymienionych (patrz zadania 1-3) funkcji celu może pełnić rolę takiego wskaźnika sprawności. Co więcej, najbardziej kwalifikujące się osobniki mają możliwość „rozmnażania się” poprzez „krzyżowanie” z innymi osobnikami w populacji. W efekcie pojawiają się nowe osobniki - „potomkowie”, którzy dziedziczą niektóre cechy po każdym ze swoich „rodziców”. Dlatego też najmniej sprawni członkowie populacji „wymierają”. Wynikająca z tego nowa populacja możliwych rozwiązań tworzy nowe „pokolenie”, które zachowuje w znacznie większym stopniu te cechy (cechy), które były właściwe najlepszym przedstawicielom poprzedniego pokolenia. Stosując opisany powyżej schemat z pokolenia na pokolenie oraz zachęcając do krzyżowania i wymiany cech przede wszystkim wśród najbardziej odpowiednich osobników, możliwe jest konsekwentne ulepszanie populacji poprzez zachowanie i pomnażanie w niej najsilniejszych aspektów osobników. Innymi słowy, poszukiwania zbadają najbardziej obiecujące, obiecujące obszary przestrzeni zmiennych parametrów. Przy prawidłowym funkcjonowaniu GA populacja zbliża się do optymalnego rozwiązania problemu.

Powszechnie przyjmuje się, że algorytmy genetyczne nie gwarantują znalezienia globalnego optimum, ale ich siła polega na tym, że pozwalają „dość szybko” znaleźć „dostatecznie dobre” rozwiązania szerokiej gamy problemów, w tym tych trudnych do rozwiązania. innymi metodami.

Historia zastosowania algorytmów genetycznych zaczyna się od prac R. Holstiena i De Jonga, w których po raz pierwszy zademonstrowano możliwości GA w rozwiązywaniu wieloparametrowych problemów optymalizacji na wielu przykładach. W 1975 roku ukazała się monografia J. Hollanda „Adaptacja w układach naturalnych i sztucznych”, w której podano teoretyczne uzasadnienie metody i sformułowano podstawowe zasady, na których się ona opiera. I wreszcie książka D. Goldberga „Algorytmy genetyczne w problemach wyszukiwania, optymalizacji i uczenia maszynowego”, opublikowana w 1989 roku i która stała się klasyką, zyskała dużą popularność, zawierająca wiele przykładów i możliwych sformułowań problemów z różnych obszary zastosowań rozwiązane za pomocą GA.

W ostatnich latach zakres aplikacji GA znacznie się rozszerzył. Wykazano, że metody te są skuteczne w rozwiązywaniu takich problemów jak:

- * identyfikacja złożonych obiektów dynamicznych;

- * dobór optymalnej konfiguracji wieloagentowych systemów robotycznych;

- * synteza optymalnych algorytmów sterowania dla manipulatorów wieloprzewodowych;

- * optymalna kontrola dokowania statków kosmicznych;

- * planowanie tras ruchu pojazdów w warunkach przeszkód;

- * synteza strukturalna rozwiązań projektowych, synteza harmonogramów

i wiele innych.

Zastosowanie GA obejmuje nie tylko klasę tradycyjnych problemów optymalizacyjnych, ale także szybko przenosi się na problemy zarządzania złożonymi obiektami dynamicznymi w warunkach niepewności. Dlatego w zadaniach sterowania oprzyrządowaniem obrabiarek GA może być również wykorzystywane do rozwiązywania szerokiego zakresu zadań.

Aby zapewnić określoną jakość przetwarzania w TO, konieczne jest zorganizowanie kontroli intelektualnej na wszystkich poziomach ISU: organizacyjnym, koordynacyjnym i taktycznym. Oznacza to, że zarówno system regulatorów, jak i jednostka do identyfikacji i prognozowania w ramach ES muszą posiadać „zdolności intelektualne”. Jako regulatory nieliniowych obiektów sterujących często stosuje się regulatory rozmyte, NS i ich odmiany, a do systemów identyfikacji i prognozowania - układy neuro-rozmyte (ANFIS - AdaptiveNeuro-FuzzyInferenceSystem) i różne typy sieci neuronowych. Same ES można również zbudować w oparciu o logikę „klarowną” lub „rozmytą”. Zatem ES można opracować na podstawie NN lub reguł rozmytych lub obu jednocześnie. Dlatego organizując inteligentne sterowanie TO, bardziej celowe jest tworzenie neurorozmytych (hybrydowych) ES, które mają szerokie możliwości wykorzystania zalet zarówno logiki rozmytej, jak i sieci neuronowych. Ponadto konieczne jest stosowanie mieszanej (hybrydowej) strategii zarządzania na wszystkich poziomach ISU TO, ponieważ pozwoli to na najpełniejsze wykorzystanie zalet inteligentnych metod zarządzania nie tylko na wyższym poziomie zarządzania (organizacyjnym i koordynacyjnym) , ale także na niższym (taktycznym) poziomie, gdzie potrzebne są nieliniowe algorytmy dla różnych strategii sterowania elementami wykonawczymi w czasie rzeczywistym.

Decyzje gospodarcze, w zależności od pewności możliwych wyników lub konsekwencji, rozpatruje się w ramach trzech modeli:

wybór rozwiązania pod pewnymi warunkami, jeśli dla każdego działania wiadomo, że prowadzi ono niezmiennie do jakiegoś wyniku;

wybór decyzji obarczonej ryzykiem, jeśli każde działanie prowadzi do jednego z wielu możliwych wyników prywatnych, a każdy wynik ma obliczone lub fachowo oszacowane prawdopodobieństwo wystąpienia;

wybór decyzji w warunkach niepewności, gdy jedno lub drugie działanie ma w konsekwencji wiele prywatnych skutków, ale ich prawdopodobieństwo jest nieznane.

Metody probabilistyczne zapewniają odpowiednie warunki do podejmowania decyzji i miarodajne gwarancje jakości wyboru. Zakłada się, że sądy dotyczące znaczeń, preferencji i intencji stanowią wartościowe abstrakcje ludzkiego doświadczenia i mogą być przetwarzane w celu podjęcia decyzji. Podczas gdy sądy o prawdopodobieństwie zdarzeń są określane przez prawdopodobieństwa, sądy o celowości działań są reprezentowane przez pojęcia. Metodologia bayesowska rozważa oczekiwaną użyteczność U (d) jako oszacowanie jakości rozwiązania d. W związku z tym, jeśli możemy wybrać akcję d 1 lub d 2, obliczamy U (d 1), U (d 2) i wybieramy akcję, która odpowiada największej wartości. Semantyka użyteczności służy do opisu ryzyka.

Potocznie ryzyko rozumiane jest jako prawdopodobieństwo (zagrożenie) utraty części zasobów przez osobę lub organizację, utratę dochodów lub pojawienie się dodatkowych kosztów w wyniku realizacji określonej polityki finansowej.

Poziom ryzyka jest rozumiany jako obiektywne lub subiektywne prawdopodobieństwo straty. Cel jest ilościową miarą możliwości wystąpienia zdarzenia losowego, uzyskaną w drodze obliczeń lub doświadczenia, która pozwala ocenić prawdopodobieństwo wykrycia danego zdarzenia. Subiektywność jest miarą pewności i prawdziwości wyrażonego orzeczenia i jest ustalana przez eksperta.

Poziom ryzyka najłatwiej jest ustalić za pomocą ocen atrybutywnych, takich jak „wysoki”, „średni”, „mały”. Rodzaj atrybucyjnej oceny ryzyka to kodowanie literowe. W tym przypadku, w kolejności rosnącego ryzyka i malejącej niezawodności, używane są łacińskie litery od A do D.

AAA - najwyższa niezawodność;

AA - bardzo wysoka niezawodność;

A - wysoka niezawodność;

D to maksymalne ryzyko.

Możliwe jest oszacowanie poziomu ryzyka za pomocą wskaźników rachunkowości i sprawozdawczości statystycznej.

Ze wszystkich możliwych wskaźników najlepiej nadaje się do tego wskaźnik bieżącej płynności (KTL) - stosunek środków płynnych partnera do jego zadłużenia, co odpowiada na pytanie, czy partner będzie w stanie pokryć zadłużenie aktywnymi aktywami płynnymi .

W wyniku analizy sytuacji budowane są diagramy przyczynowo-skutkowe („drzewo przyczyn”) oraz diagramy zależności. Diagram przyczynowo-skutkowy to formalne przedstawienie struktury sytuacji problemowej w postaci hierarchicznie otwartego grafu, którego wierzchołki odpowiadają elementom problemu, odzwierciedlając przyczyny jego wystąpienia, a łuki - do połączeń między nimi. Połączenie elementów-podproblemów jest przedstawiane w postaci relacji „przyczyna - skutek” (rys. 11.1).

OLTR - środki hurtowni danych i operacyjne przetwarzanie transakcji; OLAR - sposób przetwarzania informacji operacyjnych.

Korporacyjna baza danych zorganizowana jako hurtownia danych jest wypełniona informacjami wykorzystującymi technologie OLTR i OLAR. W celu opracowania i wdrożenia DSS dla problemów częściowo ustrukturyzowanych należy opracować i dostosować do jego warunków następujące metody i narzędzia:

system znaków służących do rejestracji sytuacji problemowych;

metody oceny stopnia krytyczności sytuacji problemowych;

diagramy przyczynowo-skutkowe do diagnozowania przyczyn sytuacji problemowych;

tabela decyzyjna do tworzenia i wyboru opcji decyzyjnych;

metody przewidywania wyników decyzji;

modele funkcjonowania przedsiębiorstwa i środowiska zewnętrznego.

Rysunek 11.1. Model systemu wspomagania decyzji

Najczęstszą formą identyfikacji problemów za pomocą wskaźników techniczno-ekonomicznych jest porównanie ich rzeczywistych wartości z wartościami standardowymi i średnimi.

Analiza logiczna przyczyn problemowych, zlokalizowanych na niższych poziomach hierarchii, pokazuje, że w wielu przypadkach pozwalają one na formułowanie opcji rozwiązywania problemów wyższego poziomu. Na przykład, jako opcje rozwiązania problemu zmniejszenia wielkości produkcji i sprzedaży produktów, możliwe są alternatywy:

wahania cen;

różne formy płatności;

spadek liczby pracowników;

zmniejszenie udziału warunkowo stałych kosztów w kosztach produkcji;

skrócenie czasu realizacji;

wzmocnienie usługi marketingowej.

W przypadku braku danych statystycznych niezbędnych do obliczenia obiektywnego prawdopodobieństwa wystąpienia ryzyka uciekają się do subiektywnych ocen opartych na intuicji i doświadczeniu ekspertów. J. Keynes wprowadził pojęcie prawdopodobieństwa subiektywnego. Zgodnie z zasadą obojętności równie prawdopodobne zdarzenia lub sądy muszą mieć to samo prawdopodobieństwo, które jest zapisane matematycznie jako:

A ~ B ≡ P (A) \u003d P (B),

gdzie ~ jest znakiem wyrażającym postawę obojętności lub tolerancji.

Bardziej prawdopodobne zdarzenie lub orzeczenie powinny mieć większe prawdopodobieństwo, tj. jeśli A\u003e B, to P (A)\u003e P (B). Subiektywne oceny prawdopodobieństwa łączą wartości słowne i ilościowe (tab.4).

Tabela 4

Dokonując transakcji na rynku papierów wartościowych wyróżnia się następujące rodzaje ryzyk:

Ryzyko systematyczne - ryzyko spadku na rynku papierów wartościowych jako całości. Nie jest powiązany z określonym zabezpieczeniem.

Ryzyko niesystematyczne to zagregowana koncepcja, która łączy wszystkie rodzaje ryzyka związane z określonym zabezpieczeniem.

Ryzyko kraju - ryzyko inwestycji w papiery wartościowe przedsiębiorstw znajdujących się pod jurysdykcją kraju o niestabilnej sytuacji społeczno-gospodarczej, nieprzyjaznych stosunkach z krajem, którego rezydentem jest inwestor. W szczególności ryzyko polityczne.

Ryzyko zmian legislacyjnych - ryzyko poniesienia strat na inwestycjach w papiery wartościowe na skutek zmiany ich wartości rynkowej spowodowanej pojawieniem się nowych lub zmianą istniejących norm prawnych.

Ryzyko inflacyjne - ryzyko, że w przypadku wysokiej inflacji dochody uzyskiwane przez inwestorów z papierów wartościowych ulegną deprecjacji.

Ryzyko walutowe - ryzyko związane z inwestycjami w walutowe papiery wartościowe, spowodowane zmianami kursu walutowego.

Ryzyko branżowe to ryzyko związane ze specyfiką poszczególnych branż.

Ryzyko regionalne to ryzyko nieodłączne w regionach wytwarzających jeden produkt (rolnictwo, wojsko, przemysł ciężki, lekki).

Ryzyko przedsiębiorstwa - ryzyko poniesienia strat finansowych z tytułu inwestycji w papiery wartościowe danego przedsiębiorstwa.

Ryzyko kredytowe - to ryzyko, że emitent, który wyemitował papiery wartościowe, nie będzie w stanie zapłacić od nich odsetek.

Ryzyko płynności - ryzyko związane z możliwością poniesienia strat przy sprzedaży papieru wartościowego w wyniku zmiany jego oceny.

Ryzyko stopy procentowej - to ryzyko strat, jakie inwestorzy mogą ponieść w związku ze zmianami stóp procentowych.

Ryzyko kapitałowe to ryzyko znacznego pogorszenia jakości portfela papierów wartościowych.

Istnieje kilka popularnych podejść do podejmowania decyzji dotyczących wyboru portfela i alokacji środków. Najprostszy, zgodny z przepisami, wymaga zaprojektowania portfela tak, aby spełniał specyficzne wymagania inwestującej firmy. Zgodnie z tym podejściem inwestor dokonuje lokat na określoną kwotę w różne kategorie papierów wartościowych. Ocena jakości papierów wartościowych firmy może być oparta na wielkości kapitału firmy, wskaźnikach jej wyników oraz wkładach innych organizacji.

Strategie, w których aktywa są mieszane zgodnie z fazami gospodarki krajowej i światowej, nazywane są taktyczną alokacją aktywów. Taktyczna alokacja aktywów może przebiegać zgodnie z zasadami inwestowania funduszy w te aktywa, które straciły na wartości. Gdy odsetek funduszy zainwestowanych w różne klasy aktywów opiera się na pewnych predykcyjnych szacunkach parametrów makroekonomicznych, podejście to nazywa się plasowaniem według scenariusza.

Najpowszechniej akceptowanym podejściem do wyboru portfela jest metoda średniej wariancji zaproponowana przez Harry'ego Markowitza. Główną ideą jest potraktowanie przyszłego dochodu generowanego przez instrument finansowy jako zmienną losową, czyli dochód z poszczególnych obiektów inwestycyjnych zmienia się losowo w określonych granicach. Następnie, jeśli w jakiś sposób określimy dla każdego obiektu inwestycyjnego całkiem określone prawdopodobieństwa realizacji, możemy otrzymać rozkład prawdopodobieństw uzyskania dochodu dla każdej alternatywy inwestowania. Dla uproszczenia model Markowitza zakłada, że \u200b\u200bzwroty rozkładają się normalnie między alternatywami inwestycyjnymi.

Zgodnie z modelem Markowitza wyznaczane są wskaźniki charakteryzujące wielkość inwestycji i ryzyko, co pozwala porównać różne alternatywy dla inwestycji kapitałowych pod względem wyznaczonych celów i tym samym stworzyć skalę do oceny różnych kombinacji. W praktyce najbardziej prawdopodobną wartością jest skala oczekiwanego dochodu z szeregu możliwych dochodów, co w przypadku rozkładu normalnego pokrywa się z oczekiwaniem matematycznym.

U podstaw modelu Markowitza wybór portfela wydaje się być problemem optymalizacji:

z ograniczeniami

,

,

,

,

gdzie n- liczba dostępnych papierów wartościowych;  część portfela zawarta w papierach wartościowych danego typu ja; R ja \u003d E (r ja) Jest oczekiwaną wartością dochodu z papierów wartościowych

ja; R p \u003d E (r p) - docelowy poziom oczekiwanego dochodu portfela; σ ij - kowariancja dochodu z papierów wartościowych ja

i jot; V p - wariancja dochodu portfela.

część portfela zawarta w papierach wartościowych danego typu ja; R ja \u003d E (r ja) Jest oczekiwaną wartością dochodu z papierów wartościowych

ja; R p \u003d E (r p) - docelowy poziom oczekiwanego dochodu portfela; σ ij - kowariancja dochodu z papierów wartościowych ja

i jot; V p - wariancja dochodu portfela.

To zadanie jest zadaniem programowania kwadratowego.

Program nr 14 badań podstawowych OEMMPU RAS

„ANALIZA I OPTYMALIZACJA FUNKCJONOWANIA WIELOPOZIOMOWYCH, INTELIGENTNYCH I SIECIOWYCH SYSTEMÓW KONTROLI W NIEPEWNOŚCI”

1. Uzasadnienie Programu

1.1. Znaczenie naukowe i praktyczne

Intensywny rozwój technologii (współdziałanie sieciowe, miniaturyzacja komputerów, zwiększanie ich szybkości itp.) Narzuca nowe wymagania nowoczesnym układom sterowania i otwiera nowe możliwości zarówno na poziomie systemów sterowania wbudowanego (na poziomie dużych centrów dyspozytorskich), jak i na poziomie sieci (komunikacja - sieć, grupa) interakcja zdecentralizowanych systemów wieloagentowych.Systemy sterowania w coraz większym stopniu nabierają charakteru informatycznych systemów sterowania i są badane na przecięciu teorii sterowania, obliczeń i komunikacji. Zatem uwzględnienie właściwości kanałów komunikacyjnych (komunikacja) jest konieczne np. W systemach zdecentralizowanych (multiagentowych), a cechy komputera wbudowanego są istotne przy implementacji takich funkcji intelektualnych w wielopoziomowych systemach sterowania jako wizja techniczna, planowanie działań, szkolenie, wielokryterialne podejmowanie decyzji, refleksja itp. itp. W szczególności intelektualizacja kontroli ma na celu zwiększenie stopnia autonomii funkcjonowania systemów, gdy brak ilościowych modeli dynamika lub zakłócenia w funkcjonowaniu obiektu sterowania, powodujące utratę adekwatności modeli ilościowych (np. równań opisujących ewolucję złożonego układu), wzmacniają rolę jakościową (tzw. wiedzy ”, np. logiczno-lingwistyczne) modele obiektu i środowiska stosowane na wyższych poziomach układu sterowania.

Program ma na celu rozwiązywanie podstawowych problemów pojawiających się w priorytetowych obszarach nauki, techniki i technologii Federacji Rosyjskiej. Zadanie polega na uzyskaniu nowych podstawowych i stosowanych wyników z zakresu teorii sterowania dla złożonych systemów technicznych, człowiek-maszyna i innych, z uwzględnieniem niepewności i braku informacji wstępnych, w tym: teorii analizy i syntezy układów stochastycznych, teoria tworzenia układów sterowania ruchem i procesami technologicznymi, z bieżącą diagnostyką i kontrolą stanu technicznego, a także teoria tworzenia zautomatyzowanych systemów projektowania i inteligentnego sterowania w oparciu o nowoczesne technologie informacyjne.

Ze względu na różnorodność wykorzystania teorii sterowania, analizy i optymalizacji w różnych zastosowaniach (transport, logistyka, produkcja, systemy lotnicze i kosmiczne, okręty podwodne i nawodne itp.) Konieczne jest uwzględnienie dużej liczby złożoności czynniki, takie jak:

Zarządzanie wielopoziomowe,

Decentralizacja,

Nieliniowość,

Wielopołączenie,

Rozkład parametrów,

Różne skale procesów w czasie i przestrzeni,

Wysoki wymiar,

Niejednorodność opisu podsystemów,

Wielomodowy,

Obecność wpływów impulsowych,

Obecność zaburzeń współrzędnościowo-parametrycznych, strukturalnych, regularnych i pojedynczych,

Wykorzystanie modeli deterministycznych i probabilistycznych do opisu niepewności informacji o wektorze stanu i parametrach systemu, o właściwościach błędów pomiarowych i środowisku,

Obecność efektów opóźnienia w sterowaniu lub obiekcie,

· Ogólna złożoność konstrukcyjna nowoczesnych systemów sterowania.

Aby osiągnąć ten cel i rozwiązać główne zadania, Program obejmuje badania i rozwój w następujących głównych obszarach:

1. Analiza i optymalizacja działania w różnych skalach czasowych wielopoziomowych systemów sterowania z niepełną informacją.

2. Zarządzanie i optymalizacja w wielopoziomowych i zdecentralizowanych systemach o charakterze organizacyjnym i technicznym.

2.1. Zarządzanie i optymalizacja w systemach sieciowych.

2.2. Inteligentna kontrola poruszających się obiektów.

2.3. Modelowanie i optymalizacja wielopoziomowych systemów informacji i sterowania w czasie rzeczywistym.

Kierunek 1. Analiza i optymalizacja funkcjonowania w różne skale czasowe wielopoziomowych systemów sterowania z niepełnymi informacjami

Złożoność wielu nowoczesnych systemów sterowania często nie pozwala na uzyskanie z wyprzedzeniem pełnego opisu procesów zachodzących w systemie i jego interakcji z otoczeniem. Z reguły układy rzeczywiste opisywane są nieliniowymi równaniami dynamiki i dość często w modelach matematycznych układów sterowania uwzględniane są tylko dopuszczalne zakresy zmienności parametrów i charakterystyk poszczególnych elementów bez określania samych tych parametrów i charakterystyk.

Ponadto w niektórych systemach, w szczególności mikromechanicznych i kwantowych, zastosowanie klasycznych metod opisu w czasie ciągłym lub dyskretnym jest utrudnione przez fakt, że powstające wewnętrzne i / lub zewnętrzne siły interakcji, a także działania kontrolne, mają charakter przejściowy, impulsywny i nie można ich dokładnie obliczyć. ... System wydaje się funkcjonować w różnych skalach czasowych: rzeczywistej (powolnej) i szybkiej (impuls). Taka czasowa zmienność skal jest nieodłączną właściwością wielu współczesnych systemów sterowania, w tym systemów z kontrolą wielopoziomową, w których na wyższych poziomach stosowane są modele jakościowe i dyskretne, a na niższych - częściej modele ilościowe z czasem ciągłym.

Z tego powodu opracowanie metod matematycznej formalizacji opisu funkcjonowania takich układów w czasie hybrydowym (ciągłym-dyskretnym), badanie ich właściwości sterowalności i stabilności w warunkach niepełnej informacji, opozycji i niestandardowych ograniczenia dotyczące kontroli i zmiennych fazowych to pilne zadanie. Równie pilnym zadaniem jest opracowanie metod syntezy optymalnej kontroli takich ciągłych układów dyskretnych, zarówno deterministycznych, jak i stochastycznych.

Ponadto w warunkach niepewności i braku informacji a priori bardzo istotne są zadania optymalizacji procesu gromadzenia i przetwarzania informacji (obserwacje monitoringowe i optymalne filtrowanie).

Kierunek 2. Zarządzanie i optymalizacja w wielopoziomowych i zdecentralizowanych systemach o charakterze organizacyjnym i technicznym

2.1. Sterowanie i optymalizacja w systemach sieciowych

Nowoczesne złożone systemy organizacyjno-techniczne charakteryzują się dużą wymiarowością, decentralizacją, wielopoziomowym zarządzaniem, potrzebą efektywnego planowania działań z uwzględnieniem szkoleń, wielokryterialnością podejmowanych decyzji oraz refleksją nad kontrolowanymi podmiotami.

Problemy planowania i sterowania dyskretnymi i ciągłymi, rozproszonymi, wielowymiarowymi systemami charakteryzują się również różnymi skalami procesów nie tylko w czasie, ale także rozkładem i różnymi skalami w przestrzeni i stanowią jedną z najbardziej złożonych i pracochłonnych klas optymalizacji problemy. Z tego powodu wskazane jest rozwijanie metod badawczych i podejść do poszukiwania trafnych i przybliżonych rozwiązań oraz narzędzi symulacyjnych do wykorzystania w systemach wspomagania decyzji do planowania, projektowania i zarządzania złożonymi technicznymi, organizacyjnymi (w tym transportowo-logistycznymi) i informacyjnymi systemy.

Aby zarządzać interakcją grupową, komponenty zdecentralizowanych systemów organizacyjnych i technicznych (systemy sieciocentryczne, systemy produkcyjne, informatyczne, telekomunikacyjne i inne sieci itp.) W kontekście ograniczeń kanałów komunikacyjnych i złożoności obliczeń mają ogromne znaczenie dla charakterystykę procesów przetwarzania informacji oraz ograniczenia czasu podejmowania decyzji, możliwości obliczeniowych i przepustowości kanału komunikacyjnego. Dlatego istotne jest opracowanie metod optymalizacji (z uwzględnieniem wymienionych ograniczeń) struktury złożonych systemów organizacyjno-technicznych, w tym przy jednoczesnym uwzględnieniu wielu kryteriów: szczegółowości danych wyjściowych, efektywności zbierania informacji, planowania i refleksyjne podejmowanie decyzji, ograniczona wydajność poszczególnych komputerów, ograniczenie powielania pracy, a także udział obliczeń pomocniczych związanych z usługami transmisji danych.

Systemy wielopoziomowe i zdecentralizowane charakteryzują się rozproszonym podejmowaniem decyzji w czasie rzeczywistym w warunkach informacyjnych środków zaradczych, a także niekompletnością i niejednorodnością informacji, często o wielokryterialnym charakterze jakościowym i subiektywnym. Z tego powodu konieczne jest wypracowanie metod tworzenia adekwatnych systemów wsparcia informacyjnego oraz wspomagania podejmowania decyzji strategicznych i operacyjnych w warunkach niepełnej informacji i sprzeciwu. W tym celu wskazane jest w szczególności opracowanie: wieloagentowych modeli dynamicznych systemów organizacyjnych i technicznych, w tym modeli sieciowych z agentami konfliktowymi, modeli zachowań grupowych i ich prognozowania, oceny bilansu interesów i tworzenia koalicji w systemy te, a także rozwój technologii informatycznych i sposobów prezentacji informacji o środowisku zewnętrznym i wiedzy inteligentnych agentów.

2.2. Inteligentna kontrola poruszających się obiektów

Modele ilościowe nie zawsze mogą być tworzone do rozwiązywania powierzonych zadań, dlatego obok tradycyjnych metod w Programie wykorzystywane są metody sztucznej inteligencji. Sztuczna inteligencja, jako dziedzina wiedzy, przeszła w ciągu ostatnich pięćdziesięciu lat ogromny skok zarówno w rozwoju i dopracowaniu samej koncepcji inteligencji, jak i praktycznego zastosowania sztucznej inteligencji w różnych dziedzinach działalności człowieka: w technologia, ekonomia, biznes, medycyna, edukacja itp. Wiele teoretycznych stanowisk i metod sztucznej inteligencji zostało przekształconych w stosowane inteligentne technologie oparte na wiedzy.

Osobliwością współczesnej generacji systemów inteligentnych jest to, że opierają się one na złożonym modelu środowiska zewnętrznego, który uwzględnia zarówno informacje ilościowe, jak i modele jakościowe - wiedzę o możliwym zachowaniu się różnych obiektów w środowisku zewnętrznym i ich wzajemnych powiązaniach. Zastosowanie takich modeli stało się możliwe dzięki rozwojowi metod reprezentacji wiedzy, metod integracji danych z różnych źródeł, znacznemu wzrostowi szybkości i pamięci komputerów.

Obecność modelu środowiska zewnętrznego pozwala nowoczesnym inteligentnym systemom sterowania poruszającymi się obiektami na podejmowanie decyzji w warunkach wielokryterialnych, niepewności i ryzyka, a jakość tych decyzji może przewyższać jakość decyzji podejmowanych przez osobę w warunkach przeciążenia informacją , ograniczony czas i stres.

W związku z tym pilnym zadaniem jest opracowanie nowych środków i metod rozwoju inteligentnego sterowania poruszającymi się obiektami w obecności powyższych czynników.

2.3. Modelowanie i optymalizacja wielopoziomowych systemów informacji i sterowania w czasie rzeczywistym

Znaczenie badań w tym kierunku wynika z konieczności opracowania metod analizy i syntezy wielopoziomowych otwartych modułowych systemów informacji i sterowania czasu rzeczywistego (IMS RT) obiektów wielomodowych i wielofunkcyjnych pracujących w warunkach niepewności, zaburzeń strukturalnych oraz sytuacje awaryjne (NSS). Te obiekty zarządzania obejmują krytyczne obiekty i systemy odpowiedzialnego użytkowania, które decydują o bezpieczeństwie państwa.

Oczywiste jest, że problemy i zadania tworzenia systemów tej klasy można z powodzeniem rozwiązać w oparciu o wypracowanie ujednoliconej teorii oraz zastosowane zorientowane programowo metody analizy dynamicznej i scenariuszowej oraz syntezy struktury takich systemów, ich algorytmiki. , oprogramowanie i wsparcie informacyjne, mechanizmy rozwijania skutecznych wpływów zarządzania. Obejmuje to przede wszystkim opracowanie sformalizowanej metodologii projektowania otwartych systemów informacyjno-sterujących, w tym modeli i metod syntezy modułowej struktury obiektowego RTT o otwartej architekturze, optymalnej ze względu na różną efektywność. kryteria. Na podstawie wyników uzyskanych na etapie analizy dynamicznej syntetyzuje się optymalną funkcjonalną modularną strukturę przetwarzania i sterowania danych, tj. Określany jest optymalny skład i liczba modułów AKPiA, syntetyzuje się interfejs systemu oraz strukturę jego określono obsługę oprogramowania i informacji do przetwarzania wejściowych przepływów aplikacji.

W celu planowania działań i wspomagania podejmowania decyzji w warunkach niepewności, zakłóceń strukturalnych i sytuacji awaryjnych, wskazane jest zastosowanie metod analizy scenariuszowej i syntezy skutecznych działań kontrolnych w ZSZ RV. W tym przypadku matematyczny model propagacji zaburzeń strukturalnych i sytuacji awaryjnych zostanie utworzony w języku ważonych lub funkcjonalnych grafów znakowych. Na podstawie tego modelu racjonalne scenariusze zarządzania obiektami zostaną zsyntetyzowane z wykorzystaniem koncepcji zdolności użytkowej, trwałości i przeżywalności elementów składowych. Synteza scenariuszy eliminacji przyczyn i skutków KIS w wielomodowych obiektach docelowych zostanie przeprowadzona z uwzględnieniem dynamicznie określanych ograniczeń czasowych i zasobowych. Konieczne jest także wypracowanie sformułowań i metod rozwiązywania odwrotnych problemów kontroli przeżywalności obiektów wielomodowych i wielofunkcyjnych pracujących w warunkach niepewności, zaburzeń strukturalnych i sytuacji awaryjnych.

Wyżej wymieniona specyfika systemów i obiektów zarządzania, naukowe i praktyczne znaczenie rozwiązywania problemów zarządzania, analizy i optymalizacji dla nich pozwalają na sformułowanie następujących głównych celów i zadań Programu.

1.2. Główne cele i zadania

Głównym celem Programu jest rozwiązanie podstawowych problemów teorii sterowania, które utrudniają realizację obiecujących projektów o istotnym znaczeniu państwowym w zakresie zarządzania złożonymi systemami dynamicznymi i inteligentnymi z aplikacjami do sterowania ruchem obiektów i procesów technicznych w technologiach i systemy organizacyjne.

Badania będą prowadzone w następujących ogólnych tematach.

Kierunek 1

· Opracowanie metod stabilizacji układów nieliniowych w sytuacjach niepełnego pomiaru współrzędnych i ograniczeń dopuszczalnej struktury sił sterujących.

· Opracowanie metod solidnej i adaptacyjnej obserwacji i sterowania w warunkach deterministycznych, probabilistycznych i innych modeli niepewności parametrów obiektu kontrolnego i środowiska funkcjonowania.

· Opracowanie metod i algorytmów do jakościowej i ilościowej analizy ciągłych, dyskretnych i wielopoziomowych ciągłych i dyskretnych modeli dynamicznych oraz syntezy sterującej opartej na metodzie redukcji z wektorowymi i macierzowymi funkcjami porównawczymi oraz transformacjami modeli.

· Badanie problemu optymalnego sterowania nową klasą układów mechanicznych poruszających się w mediach oporowych w wyniku zmian konfiguracji lub ruchu ciał wewnętrznych.

· Opracowanie metod formalizacji matematycznej i rozwiązywania problemów oddziaływania uderzeniowego układów mechanicznych w obecności tarcia suchego.

· Opracowanie metod optymalnego sterowania układami dyskretno-ciągłymi i dynamicznymi impulsowo.

· Opracowanie metod gwarantowanej kontroli obiektów nieliniowych narażonych na niekontrolowane zakłócenia w postaci gier dynamicznych.

· Rozwój teorii sterowania systemami kwantowymi.

· Opracowanie metod i algorytmów analizy właściwości dynamicznych, takich jak stabilność, niezmienność, dyssypatywność, do oceny stanu i syntezy wielopoziomowego sterowania systemami z niejednorodnym opisem dynamiki procesów na różnych poziomach.

Kierunek 2.1

· Metody rozwiązywania problemów sterowania dla systemów sieciowych centrycznych o dużych wymiarach o rozłożonych parametrach i procesach o różnej skali (w przestrzeni i czasie).

· Modele i metody komunikacji zdecentralizowanej sieci inteligentnego zarządzania rozproszonymi projektami i programami.

· Metody optymalizacji struktury systemów wielopoziomowych i zdecentralizowanych.

· Metody i struktury komputerowej implementacji sterowania sieciowego w matematycznie jednorodnej przestrzeni obliczeń rozproszonych i równoległych.

· Modele i metody grupowego podejmowania decyzji w oparciu o niepełne, niejednorodne, jakościowe i subiektywne informacje.

· Modele i metody planowania i zarządzania kompleksami wzajemnie powiązanych operacji w złożonych systemach technicznych i transportowo-logistycznych.

· Opracowanie zasad, architektury, metod i algorytmów tworzenia rozproszonych inteligentnych systemów programowych opartych na technologiach wieloagentowych.

· Opracowanie modeli i metod zarządzania informacją w strukturach sieci wieloagentowych.

Kierunek2.2

· Opracowanie uogólnionych modeli zarządzania sytuacyjnego, odzwierciedlających cechy włączenia w strukturę modeli rozmytych, sieci neuronowych i elementów logiczno-dynamicznych.

· Opracowanie metody planowania tras dających właściwość stabilności komunikacyjnej grupy kontrolowanych obiektów dynamicznych, heterogenicznych (ilościowych i jakościowych) w reprezentacji modelowej.

· Opracowanie metod analizy i syntezy adaptacyjnych platform modelowania w czasie rzeczywistym z uwzględnieniem nieliniowości, wielozłączności, dużych wymiarów obiektów sterujących z zastosowaniem do morskich obiektów mobilnych.

· Optymalizacja inteligentnych systemów wielopoziomowego sterowania poruszającymi się obiektami w środowisku konfliktowym z uwzględnieniem ich interakcji grupowej, wielokryterialnej, niepewności i ryzyka.

· Rozwój metod zapewniania wizji technicznej dla inteligentnych systemów sterowania.

· Opracowanie metod inteligentnego sterowania obiektami dynamicznymi wykonującymi złożone manewry w oparciu o organizację wymuszonego ruchu w przestrzeni stanów systemu.

Kierunek2.3

· Modele i metody analizy i optymalizacji modułowej struktury obiektowych, wielopoziomowych systemów zarządzania informacją czasu rzeczywistego o otwartej architekturze w warunkach niepewności i zaburzeń strukturalnych.

· Metody analizy i optymalizacji trybów pracy systemów elektroenergetycznych oraz ich sterowania.

· Modele i metody podejścia scenariuszowego do poszukiwania punktów podatności na zadania zarządcze.

· Metody modelowania, analizy i optymalizacji wielomodowych procesów sterowania poruszającymi się obiektami.

· Opracowanie metod i algorytmów inteligentnej identyfikacji nieliniowych obiektów niestacjonarnych w celu poprawy efektywności sterowania poprzez tworzenie technologicznej bazy wiedzy w oparciu o informacje a priori o obiekcie sterowania.

· Technologie geoinformacyjne do modelowania kompleksów naturalnych i technogennych w zadaniach zarządzania ekosystemami megalopoli.

· Analiza i optymalizacja obsługi informacyjnej systemów nawigacji i sterowania.

· Modele i metody zarządzania procesami produkcyjnymi.

Wyniki opracowanej teorii oraz metody analizy i syntezy układów sterowania zostaną wykorzystane w następujących obszarach:

· kontrola ruchu w lotnictwie i astronautyce, obiekty lądowe i morskie, pojazdy;

· wieloagentowe systemy sieciocentryczne, systemy produkcyjne, informatyczne, telekomunikacyjne i inne sieci ;

· systemy transportowe i logistyczne ;

· Globalna energia, przesył gazu i inne systemy infrastruktury na dużą skalę;

· Systemy wsparcia informacyjnego dla zadań zarządczych oraz wspomagania decyzji strategicznych i operacyjnych w warunkach niepełnej informacji i sprzeciwu.

Podstawowe problemy teorii konstruowania układów sterowania wymagają ich intensywnego rozwoju. Rozwój badań w tym kierunku pozwoli:

Opracowanie teoretycznych podstaw do rozwiązania złożonego, trójjedynego problemu sterowania-obliczania-komunikacji (problem jest Kontrola- Obliczenie- Komunikacja") dla złożonych systemów informatycznych i kontrolnych, w tym w warunkach ograniczeń kanałów komunikacyjnych i awarii podsystemów;

Rozwiązywanie problemów związanych z zarządzaniem zasadniczo nowymi obiektami i procesami związanymi z obiektami ruchomymi, obiektami specjalnego przeznaczenia, systemami technologicznymi i organizacyjnymi;

Stworzenie skutecznych metod diagnostyki funkcjonalnej i zapewnienia odporności na uszkodzenia układów sterowania samolotów i innych obiektów ruchomych, a także stabilności dynamicznej układów elektroenergetycznych;

Poprawa jakości, przyspieszenie i obniżenie kosztów rozwoju rozwiązań projektowych poprzez algorytmizację i automatyzację procesu tworzenia układów sterowania.

W dalszej części sterowanie rozumiane jest szeroko, w tym sterowanie komunikacyjne, grupowe, rozproszone (w literaturze anglojęzycznej - sterowanie w sieciach, sterowanie w sieciach, sterowanie rozproszone itp.)